使用 GPT-4 Omni 进行一致的角色创建:探索其功能

探索 GPT-4 Omni 的强大功能,这是 OpenAI 最新的 AI 模型,可以在实时交互中无缝集成音频、视觉和文本。发现它的速度、成本效益以及在多个场景中创造一致角色的能力,这使它成为开发人员和内容创作者的游戏规则改变者。

2025年2月15日

探索最新的人工智能技术进展,包括 GPT-4 Omni 的发布,如何革新人机交互,开创创造一致且引人入胜的数字体验的新可能性。本博客文章探讨了这项尖端技术的功能以及其对各行业的潜在影响。

探索 GPT-4 Omni 的功能

GPT-4 Omni 的定价和成本效率

模型评估和基准测试

语言分词和表示

GPT-4 Omni 的安全性和局限性

获取和访问 GPT-4 Omni 的可用性

使用 GPT-4 Omni 创建一致的角色

结论

探索 GPT-4 Omni 的功能

探索 GPT-4 Omni 的功能

近期,OpenAI发布了GPT-4 Omni,这是一个强大的模型,可以实时跨音频、视觉和文本进行推理。这个新模型提供了几项令人印象深刻的功能:

-

多模态交互: GPT-4 Omni可以接受文本、音频、图像和视频形式的输入,并以这些模态的任意组合生成输出。这允许更自然的人机交互。

-

快速响应: 该模型平均可在232毫秒内响应音频输入,与人类对话的速度相匹配。

-

性能提升: GPT-4 Omni在各种基准测试中表现优于之前的模型,包括文本评估、音频ASR和音频翻译。

-

成本效率: 新模型比之前的GPT-4 Turbo便宜50%,使其对API用户更加可访问。ChatGPT的免费版本现在使用GPT-4 Omni,让更多用户受益于其功能。

GPT-4 Omni 的定价和成本效率

GPT-4 Omni 的定价和成本效率

GPT-4 Omni的发布带来了定价和成本效率方面的重大改进,相比之前的模型有以下关键亮点:

- 输入成本降至每1,000个令牌0.005美元,之前为GPT-4 Turbo的0.01美元。

- 输出成本现为每1,000个令牌0.015美元,之前为GPT-4 Turbo的0.03美元。

- 视觉定价也大幅降低,使GPT-4 Omni的整体使用更加经济实惠。

- 与GPT-3.5 Turbo相比,GPT-4 Omni价格下降50%,使其成为开发者和用户更可访问的选择。

- ChatGPT的免费版本现在使用GPT-4 Omni模型,让更多用户以无额外费用的方式获得改进的功能和性能。

- 有了这些定价变化,文章建议几乎没有理由再使用旧的GPT-4 Turbo模型,因为GPT-4 Omni提供更出色的性能和成本效率。

模型评估和基准测试

模型评估和基准测试

OpenAI已经通过各种基准测试来评估GPT-4 Omni模型的性能。该模型与其他语言模型如GPT-4 Turbo、原版GPT-4、Claude 3、Opus Gemini Pro 1.5、Gemini 1.0和LLaMA 3进行了比较。

结果显示,GPT-4 Omni在不同测试类别中几乎全面超越其他模型:

- 文本评估: GPT-4 Omni获得最高分数。

- 音频ASR(自动语音识别): GPT-4 Omni优于之前的Whisper版本3,错误率更低。

- 音频翻译: GPT-4 Omni战胜所有其他模型。

- M3考试零样本: GPT-4 Omni优于原版GPT-4模型。

- 视觉理解评估: GPT-4 Omni在每项测试中都获得最高分数。

文章还提到,GPT-4 Omni改进的语言分词能力有助于其成本效率。尽管英语的令牌减少只有1.1倍,但在大量文本中的节省可能很显著。

语言分词和表示

语言分词和表示

文章指出,GPT-4 Omni更便宜的一个原因是它能用更少的令牌来表示语言。尽管英语的令牌数只下降了1.1倍,但当扩展到数十万个词时,这可以带来显著的成本节省。

文章解释说,之前需要27个令牌的完整句子现在只需要24个令牌。这种改进的语言分词和表示使GPT-4 Omni能更高效地使用令牌,从而实现了与之前模型相比50%的成本降低。

文章认为,这种增强的语言建模能力是使GPT-4 Omni成为开发者和用户更具成本效益选择的关键因素,特别是对于需要处理大量跨多语言文本的应用程序。

GPT-4 Omni 的安全性和局限性

GPT-4 Omni 的安全性和局限性

与他们的所有AI模型一样,OpenAI非常关注GPT-4 Omni的安全性和局限性。文章指出,该模型仍有一些局限性,比如偶尔会中断对话,需要手动告知用户何时停止说话。即使有了GPT-4 Omni改进的响应速度,这个问题仍然存在。

文章还提到,该模型内置了安全功能和限制,以应对潜在的滥用或有害输出。但是,这些安全措施的具体细节在本节中并未提供。

总的来说,虽然GPT-4 Omni代表了OpenAI语言模型的重大进步,但该公司仍然谨慎和警惕地关注该技术的潜在风险和局限性。随着该模型被更广泛地部署,对其安全功能的持续监控和改进很可能会成为一个优先事项。

获取和访问 GPT-4 Omni 的可用性

获取和访问 GPT-4 Omni 的可用性

OpenAI的最新旗舰模型GPT-4 Omni现已广泛可用和可访问。以下是关键细节:

- GPT-4 Omni文本和图像模型现已集成到ChatGPT的免费版本中,让所有用户都可以访问这些功能。

- ChatGPT的免费版本现在的消息限制提高了5倍,使其更加可访问。

- 计划在未来几周内推出一个新版本的语音模式,集成了GPT-4 Omni,提供无缝的基于音频的交互。

- GPT-4 Omni可作为独立的文本和视觉模型通过OpenAI API获得,与之前的GPT-4 Turbo相比,速度提高了一倍,价格降低了一半。

- OpenAI强烈鼓励所有开发者转向使用GPT-4 Omni,因为它已成为首选,几乎没有使用旧GPT-4 Turbo模型的用例。

- GPT-4 Omni的定价大幅下降,输入成本降至每1,000个令牌0.005美元,输出成本为每1,000个令牌0.015美元,使其对广泛应用程序更加可访问。

总之,GPT-4 Omni的可用性和可访问性大大提高,该模型已集成到ChatGPT的免费版本中,并通过OpenAI API以更实惠的价格提供,使其成为开发者和用户的理想选择。

使用 GPT-4 Omni 创建一致的角色

使用 GPT-4 Omni 创建一致的角色

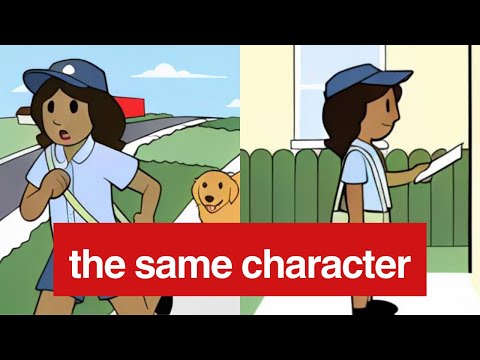

在多个场景中保持角色一致性是新GPT-4 Omni模型的一项关键功能。通过对视觉输入的训练,该模型现在可以生成保持相同角色属性(如服装、配饰和姿势)的视觉输出,即使角色被置于不同的场景中。

在提供的示例中,该模型能够始终如一地描绘"Sally"这个角色为微笑的邮递员,她的包和制服在不同场景中保持不变。这是相比之前模型的显著改进,后者不得不依赖文本描述来尝试维持角色一致性。

GPT-4 Omni视觉输出的速度和准确性也允许更流畅自然的交互,模型可以快速响应视觉提示并生成适当的视觉响应。这为需要保持角色一致性的应用程序,如互动讲述、虚拟助手和甚至游戏开发,开辟了新的可能性。

尽管ChatGPT界面中的示例可能无法完全展示该模型的功能,但GPT-4 Omni的一致角色创建能力是明显的。开发者可以利用这一功能创造更吸引人和沉浸式的用户体验,并进一步探索多模态AI系统的可能性。

结论

结论

OpenAI的新GPT-4 Omni模型是自然语言处理领域的一个重大进步,它结合了文本、音频和视觉输入,提供了实时、人性化的交互。该模型在各种基准测试中的出色表现,以及其降低的成本和增加的可访问性,使其成为开发者和用户的理想选择。

然而,作者对该模型在多个场景中保持角色表示一致性的探索突出了这一领域的持续挑战。虽然公告文章中提供的示例表明该模型可以保留视觉细节,但作者在ChatGPT界面中的自身实验表明,这种功能可能并不像宣称的那么强大。

作者建议使用API而不是ChatGPT界面来测试该模型的角色一致性,因为后者可能受到额外的安全和审核限制,从而影响模型的性能。最终,需要进一步的测试和实验,才能完全理解该模型在这方面的能力。

总的来说,GPT-4 Omni的发布代表了多模态AI领域的一个令人兴奋的进步,而作者的见解为该模型的优势和需要进一步改进的领域提供了宝贵的视角。

FAQ

FAQ