Création de personnages cohérente avec GPT-4 Omni : Exploration des capacités

Explorez les puissantes capacités de GPT-4 Omni, le dernier modèle d'IA d'OpenAI qui peut intégrer de manière transparente l'audio, la vision et le texte dans des interactions en temps réel. Découvrez sa vitesse, son rapport coût-efficacité et sa capacité à créer des personnages cohérents dans plusieurs scènes, ce qui en fait un jeu de changement pour les développeurs et les créateurs de contenu.

22 avril 2025

Découvrez comment les dernières avancées de l'IA, notamment la sortie de GPT-4 Omni, révolutionnent les interactions homme-machine et ouvrent de nouvelles possibilités pour créer des expériences numériques cohérentes et attrayantes. Cet article de blog explore les capacités de cette technologie de pointe et son impact potentiel sur divers secteurs.

Exploration des capacités de GPT-4 Omni

Tarification et rentabilité de GPT-4 Omni

Évaluations de modèles et référencement

Tokenisation et représentation linguistique

Sécurité et limites de GPT-4 Omni

Disponibilité et accès à GPT-4 Omni

Création de personnages cohérents avec GPT-4 Omni

Conclusion

Exploration des capacités de GPT-4 Omni

Exploration des capacités de GPT-4 Omni

La récente sortie de GPT-4 Omni par OpenAI a introduit un modèle puissant capable de raisonner en temps réel sur l'audio, la vision et le texte. Ce nouveau modèle offre plusieurs capacités impressionnantes :

-

Interaction multimodale : GPT-4 Omni peut accepter des entrées sous forme de texte, d'audio, d'images et de vidéos, et générer des sorties dans n'importe quelle combinaison de ces modalités. Cela permet des interactions homme-machine plus naturelles.

-

Réponse rapide : Le modèle peut répondre à des entrées audio en seulement 232 millisecondes en moyenne, correspondant à la vitesse d'une conversation humaine.

-

Performances améliorées : GPT-4 Omni surpasse les modèles précédents sur divers benchmarks, notamment l'évaluation du texte, la reconnaissance vocale ASR et la traduction audio.

-

Rentabilité : Le nouveau modèle est 50 % moins cher que le précédent GPT-4 Turbo, le rendant plus accessible pour les utilisateurs d'API. La version gratuite de ChatGPT utilise maintenant GPT-4 Omni, permettant à plus d'utilisateurs de bénéficier de ses capacités.

Tarification et rentabilité de GPT-4 Omni

Tarification et rentabilité de GPT-4 Omni

L'annonce de GPT-4 Omni apporte des améliorations significatives en termes de tarification et de rentabilité par rapport aux modèles précédents. Voici quelques points clés :

- Le coût d'entrée a chuté à 0,005 $ pour 1 000 jetons, contre 0,01 $ pour GPT-4 Turbo.

- Le coût de sortie est maintenant de 0,015 $ pour 1 000 jetons, contre 0,03 $ pour GPT-4 Turbo.

- La tarification de la vision est également beaucoup moins chère, rendant l'utilisation globale de GPT-4 Omni plus rentable.

- Par rapport à GPT-3.5 Turbo, GPT-4 Omni offre une réduction de prix de 50 %, le rendant plus accessible aux développeurs et aux utilisateurs.

- La version gratuite de ChatGPT utilise désormais le modèle GPT-4 Omni, permettant à plus d'utilisateurs de bénéficier des capacités et des performances améliorées sans frais supplémentaires.

Évaluations de modèles et référencement

Évaluations de modèles et référencement

Open AI a soumis le nouveau modèle GPT-4 Omni à divers tests de référence pour évaluer ses performances. Le modèle a été comparé à d'autres modèles de langage tels que GPT-4 Turbo, le GPT-4 original, Claude 3, Opus Gemini Pro 1.5, Gemini 1.0 et LLaMA 3.

Les résultats montrent que GPT-4 Omni surpasse presque tous les autres modèles dans différentes catégories de tests :

- Évaluation du texte : GPT-4 Omni obtient les meilleurs scores.

- ASR audio (reconnaissance vocale automatique) : GPT-4 Omni surpasse la version précédente du modèle Whisper 3, avec des taux d'erreur plus faibles.

- Traduction audio : GPT-4 Omni bat tous les autres modèles dans ce test.

- Examen M3 Zero-Shot : GPT-4 Omni surpasse le modèle GPT-4 original.

- Évaluations de la compréhension visuelle : GPT-4 Omni obtient les meilleurs scores sur chacun de ces tests.

Tokenisation et représentation linguistique

Tokenisation et représentation linguistique

L'article indique que les capacités améliorées de tokenisation du langage de GPT-4 Omni contribuent à sa rentabilité. Bien que la réduction des jetons pour l'anglais ne soit que de 1,1 fois, les économies peuvent être significatives lorsqu'elles sont mises à l'échelle sur de grandes quantités de texte.

Sécurité et limites de GPT-4 Omni

Sécurité et limites de GPT-4 Omni

Comme tous leurs modèles d'IA, OpenAI est très concentré sur la sécurité et les limites de GPT-4 Omni. L'article note que le modèle a encore quelques limites, comme interrompre occasionnellement les conversations et devoir être informé manuellement lorsque l'utilisateur a fini de parler. Il s'agit d'un problème qui persiste même avec les temps de réponse améliorés de GPT-4 Omni.

L'article mentionne également que le modèle comporte des fonctionnalités et des limites de sécurité intégrées pour faire face à une utilisation abusive ou à des résultats potentiellement nuisibles. Cependant, les détails spécifiques de ces mesures de sécurité ne sont pas fournis dans cette section.

Disponibilité et accès à GPT-4 Omni

Disponibilité et accès à GPT-4 Omni

GPT-4 Omni, le dernier modèle phare d'OpenAI, est désormais largement disponible et accessible aux utilisateurs. Voici les principales informations :

- Les modèles texte et image de GPT-4 Omni sont maintenant intégrés dans la version gratuite de ChatGPT, permettant à tous les utilisateurs d'accéder à ces capacités.

- La version gratuite de ChatGPT a désormais des limites de messages 5 fois plus élevées, la rendant beaucoup plus accessible aux utilisateurs.

- Une nouvelle version du mode vocal avec intégration de GPT-4 Omni est prévue pour être déployée dans les prochaines semaines, offrant des interactions fluides basées sur l'audio.

- GPT-4 Omni est disponible en tant que modèle de texte et de vision autonome via l'API OpenAI, offrant aux développeurs le double de la vitesse et la moitié du prix par rapport au modèle précédent GPT-4 Turbo.

Création de personnages cohérents avec GPT-4 Omni

Création de personnages cohérents avec GPT-4 Omni

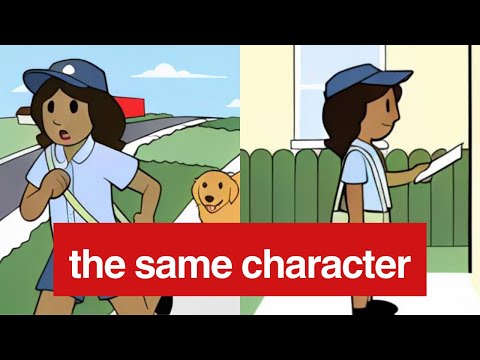

La capacité de créer des personnages cohérents dans plusieurs scènes est une fonctionnalité clé du nouveau modèle GPT-4 Omni. En s'entraînant sur des entrées visuelles, le modèle peut maintenant générer des sorties visuelles qui conservent les mêmes attributs de personnage, tels que les vêtements, les accessoires et les poses, même lorsque le personnage est placé dans différents scénarios.

Dans les exemples fournis, le modèle est capable de représenter de manière cohérente le personnage de "Sally" en tant que factrice souriante, avec son sac et son uniforme restant les mêmes dans différentes scènes. Il s'agit d'une amélioration significative par rapport aux modèles précédents, qui devaient s'appuyer sur des descriptions textuelles pour essayer de maintenir la cohérence des personnages.

La vitesse et la précision des sorties visuelles de GPT-4 Omni permettent également des interactions plus fluides et naturelles, où le modèle peut répondre rapidement aux invites visuelles et générer des réponses visuelles appropriées. Cela ouvre de nouvelles possibilités pour des applications nécessitant une représentation cohérente des personnages, comme la narration interactive, les assistants virtuels et même le développement de jeux vidéo.

Conclusion

Conclusion

Le nouveau modèle GPT-4 Omni d'OpenAI est une avancée significative dans le traitement du langage naturel, combinant les entrées texte, audio et visuelles pour fournir des interactions en temps réel, à l'image des interactions humaines. Les performances impressionnantes du modèle sur divers benchmarks, ainsi que sa réduction de coût et son accessibilité accrue, en font un choix convaincant pour les développeurs et les utilisateurs.

Cependant, l'exploration par l'auteur de la capacité du modèle à maintenir des représentations cohérentes des personnages dans plusieurs scènes met en lumière les défis persistants dans ce domaine. Bien que les exemples fournis dans l'article d'annonce suggèrent que le modèle peut préserver les détails visuels, les propres expériences de l'auteur dans l'interface ChatGPT indiquent que cette capacité n'est peut-être pas aussi robuste que revendiqué.

La suggestion de l'auteur de tester la cohérence des personnages du modèle à l'aide de l'API, plutôt que de l'interface ChatGPT, est valable, car cette dernière peut être soumise à des contraintes de sécurité et de modération supplémentaires pouvant affecter les performances du modèle. En fin de compte, des tests et des expérimentations supplémentaires seront nécessaires pour comprendre pleinement l'étendue des capacités du modèle à cet égard.

FAQ

FAQ