使用 GPT-4 Omni 一致的角色創造:探索其功能

探索 GPT-4 Omni 的強大功能,這是 OpenAI 最新的 AI 模型,可以在實時互動中無縫整合音頻、視覺和文本。發現它的速度、成本效益以及在多個場景中創造一致角色的能力,這使它成為開發人員和內容創作者的遊戲規則改變者。

2025年2月24日

探索最新的人工智能進展,包括 GPT-4 Omni 的發佈,如何革新人機互動,並開創創造一致且引人入勝的數位體驗的新可能性。本部落格文章探討這項尖端技術的功能,以及其對各行各業的潛在影響。

探索 GPT-4 Omni 的功能

GPT-4 Omni 的定價和成本效益

模型評估和基準測試

語言分詞和表示

GPT-4 Omni 的安全性和局限性

獲取和使用 GPT-4 Omni 的可用性

使用 GPT-4 Omni 創建一致的角色

結論

探索 GPT-4 Omni 的功能

探索 GPT-4 Omni 的功能

近期 OpenAI 發布的 GPT-4 Omni 引入了一個強大的模型,可以實時跨音頻、視覺和文本進行推理。這個新模型提供了幾項令人印象深刻的功能:

-

多模態交互: GPT-4 Omni 可以接受文本、音頻、圖像和視頻形式的輸入,並以這些模態的任意組合生成輸出。這允許更自然的人機交互。

-

快速響應: 該模型平均可在 232 毫秒內響應音頻輸入,與人類對話的速度相匹配。

-

性能提升: GPT-4 Omni 在各種基準測試中都優於之前的模型,包括文本評估、音頻 ASR 和音頻翻譯。

-

成本效率: 新模型比之前的 GPT-4 Turbo 便宜 50%,使其對 API 用戶更加可及。ChatGPT 的免費版本現在使用 GPT-4 Omni,使更多用戶受益於其功能。

GPT-4 Omni 的定價和成本效益

GPT-4 Omni 的定價和成本效益

GPT-4 Omni 的發布帶來了定價和成本效率方面的重大改進,相比之前的模型有以下關鍵亮點:

- 輸入成本降至每 1,000 個令牌 $0.005,之前 GPT-4 Turbo 為每 1,000 個令牌 $0.01。

- 輸出成本現在為每 1,000 個令牌 $0.015,之前 GPT-4 Turbo 為每 1,000 個令牌 $0.03。

- 視覺定價也大幅降低,使 GPT-4 Omni 的整體使用更加經濟實惠。

- 與 GPT-3.5 Turbo 相比,GPT-4 Omni 價格下降 50%,使其成為開發者和用戶更可負擔的選擇。

- ChatGPT 的免費版本現在使用 GPT-4 Omni 模型,使更多用戶以無額外費用的方式受益於其改進的功能和性能。

- 有了這些定價變化,文章建議幾乎沒有理由再使用舊的 GPT-4 Turbo 模型,因為 GPT-4 Omni 提供更優秀的性能和成本效率。

模型評估和基準測試

模型評估和基準測試

OpenAI 已經通過各種基準測試來評估 GPT-4 Omni 模型的性能。該模型與其他語言模型如 GPT-4 Turbo、原版 GPT-4、Claude 3、Opus Gemini Pro 1.5、Gemini 1.0 和 LLaMA 3 進行了比較。

結果顯示,GPT-4 Omni 在不同測試類別中幾乎全面優於其他模型:

- 文本評估: GPT-4 Omni 獲得最高分數。

- 音頻 ASR (自動語音識別): GPT-4 Omni 優於之前的 Whisper 版本 3 模型,錯誤率更低。

- 音頻翻譯: GPT-4 Omni 戰勝所有其他模型。

- M3 Exam Zero-Shot: GPT-4 Omni 優於原版 GPT-4 模型。

- 視覺理解評估: GPT-4 Omni 在每項測試中都獲得最高分數。

語言分詞和表示

語言分詞和表示

文章指出,GPT-4 Omni 更好的語言分詞能力是其成本效率的一個關鍵因素。儘管英語的令牌減少只有 1.1 倍,但在大量文本中的節省可能是巨大的。

文章解釋說,之前需要 27 個令牌的完整句子現在只需 24 個令牌。這種改進的語言建模能力使 GPT-4 Omni 能夠更有效地使用令牌,從而實現了與之前模型相比 50% 的成本降低。

文章認為,這種增強的語言建模能力是使 GPT-4 Omni 成為開發者和用戶更具成本效益選擇的關鍵因素,尤其是對於需要處理大量跨語言文本的應用程序。

GPT-4 Omni 的安全性和局限性

GPT-4 Omni 的安全性和局限性

與他們所有的 AI 模型一樣,OpenAI 非常關注 GPT-4 Omni 的安全性和局限性。文章指出,該模型仍然存在一些限制,例如偶爾會中斷對話,需要手動告知用戶何時完成發言。即使有了 GPT-4 Omni 的改進響應時間,這個問題仍然存在。

文章還提到,該模型內置了安全功能和限制,以解決潛在的濫用或有害輸出。但是,這些安全措施的具體細節在本節中並未提供。

總的來說,雖然 GPT-4 Omni 代表了 OpenAI 語言模型的重大進步,但該公司仍然謹慎和警惕地關注這項技術的潛在風險和局限性。隨著該模型被更廣泛地部署,持續監控和完善其安全功能很可能會成為一個優先事項。

獲取和使用 GPT-4 Omni 的可用性

獲取和使用 GPT-4 Omni 的可用性

OpenAI 的最新旗艦模型 GPT-4 Omni 現已廣泛可用和可訪問。以下是關鍵細節:

- GPT-4 Omni 文本和圖像模型現已集成到 ChatGPT 的免費版本中,使所有用戶都可以訪問這些功能。

- ChatGPT 的免費版本現在有 5 倍更高的消息限制,使其對用戶更加可及。

- 計劃在未來幾週內推出一個新版本的語音模式,並與 GPT-4 Omni 集成,提供無縫的基於音頻的交互。

- GPT-4 Omni 可作為獨立的文本和視覺模型通過 OpenAI API 獲得,與之前的 GPT-4 Turbo 模型相比,速度提高一倍,價格降低一半。

- OpenAI 強烈鼓勵所有開發者轉向使用 GPT-4 Omni 模型,因為它已成為首選,幾乎沒有使用舊版 GPT-4 Turbo 模型的用例。

- GPT-4 Omni 的定價已大幅降低,輸入成本降至每 1,000 個令牌 $0.005,輸出成本為每 1,000 個令牌 $0.015,使其對更廣泛的應用程序更加可及。

總之,GPT-4 Omni 的可用性和可訪問性已大大提高,該模型已集成到 ChatGPT 的免費版本中,並通過 OpenAI API 以更實惠的價格提供,使其成為開發者和用戶的引人注目的選擇。

使用 GPT-4 Omni 創建一致的角色

使用 GPT-4 Omni 創建一致的角色

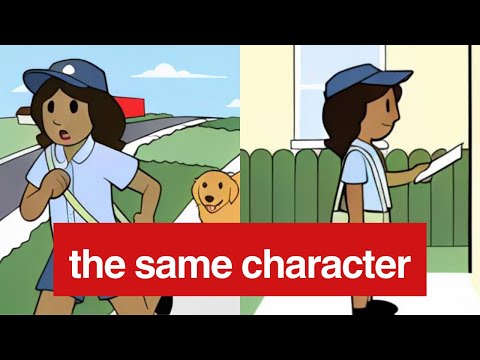

在多個場景中創造一致的角色是新 GPT-4 Omni 模型的一項關鍵功能。通過對視覺輸入的訓練,該模型現在可以生成保持相同角色屬性(如服裝、配飾和姿勢)的視覺輸出,即使角色被置於不同的場景中。

在提供的示例中,該模型能夠一致地描繪「莎莉」這個角色為微笑的郵遞員,無論她置身於何種場景,她的包裹和制服都保持不變。這是相比之前的模型的一個重大進步,後者不得不依賴文本描述來試圖維持角色一致性。

GPT-4 Omni 視覺輸出的速度和準確性也允許更流暢自然的交互,模型可以快速響應視覺提示並生成適當的視覺響應。這為需要一致角色表現的應用程序,如互動式講述、虛擬助手和甚至遊戲開發,開闢了新的可能性。

雖然 ChatGPT 界面中的示例可能無法完全展示該模型的功能,但 GPT-4 Omni 在一致角色創造方面的潛力是明顯的。開發者可以利用這一功能創造更吸引人和沉浸式的用戶體驗,並進一步探索多模態 AI 系統的可能性。

結論

結論

OpenAI 的新 GPT-4 Omni 模型是自然語言處理領域的一個重大進步,結合了文本、音頻和視覺輸入,提供實時的人性化交互。該模型在各種基準測試中的出色表現,以及其降低的成本和增加的可訪問性,使其成為開發者和用戶的引人注目選擇。

然而,作者對該模型在多個場景中維持一致角色表現能力的探索突出了這一領域的持續挑戰。雖然公告文章中提供的示例表明該模型可以保留視覺細節,但作者在 ChatGPT 界面中的自身實驗卻表明,這一功能可能並不像聲稱的那樣強大。

作者建議使用 API 而不是 ChatGPT 界面來測試模型的角色一致性的建議是合理的,因為後者可能受到額外的安全和調節限制,這可能會影響模型的性能。最終,需要進一步的測試和實驗,才能完全理解該模型在這方面的能力。

總的來說,GPT-4 Omni 的發布代表了多模態 AI 領域的一個令人興奮的進步,而作者的見解為我們提供了一個有價值的視角,既看到了該模型的優勢,也看到了需要進一步完善的領域。

常問問題

常問問題