Konsekvent karaktärsskapande med GPT-4 Omni: Utforska möjligheterna

Utforska de kraftfulla möjligheterna med GPT-4 Omni, OpenAI:s senaste AI-modell som kan integrera ljud, vision och text i realtidsinteraktioner på ett sömlöst sätt. Upptäck dess hastighet, kostnadseffektivitet och förmåga att skapa konsekventa karaktärer över flera scener, vilket gör den till en banbrytande lösning för utvecklare och innehållsskapare.

19 april 2025

Upptäck hur de senaste framstegen inom AI, inklusive lanseringen av GPT-4 Omni, revolutionerar interaktionen mellan människa och dator och öppnar upp nya möjligheter för att skapa konsekventa och engagerande digitala upplevelser. Den här blogginlägget utforskar möjligheterna hos denna banbrytande teknik och dess potentiella inverkan på olika branscher.

Utforska möjligheterna med GPT-4 Omni

Prissättning och kostnadseffektivitet för GPT-4 Omni

Modellvärderingar och benchmarking

Språktokenisering och representation

Säkerhet och begränsningar för GPT-4 Omni

Tillgänglighet och åtkomst till GPT-4 Omni

Konsekvent karaktärsskapande med GPT-4 Omni

Slutsats

Utforska möjligheterna med GPT-4 Omni

Utforska möjligheterna med GPT-4 Omni

OpenAI:s senaste lansering av GPT-4 Omni har introducerat en kraftfull modell som kan resonera över ljud, vision och text i realtid. Denna nya modell erbjuder flera imponerande funktioner:

-

Multimodal interaktion: GPT-4 Omni kan ta emot indata i form av text, ljud, bilder och video, och generera utdata i valfri kombination av dessa modaliteter. Detta möjliggör mer naturliga människa-dator-interaktioner.

-

Snabbt svar: Modellen kan svara på ljudindata på i genomsnitt 232 millisekunder, vilket matchar hastigheten för mänsklig konversation.

-

Förbättrad prestanda: GPT-4 Omni överträffar tidigare modeller på olika mätningar, inklusive textutvärdering, ljud-ASR och ljudöversättning.

-

Kostnadseffektivitet: Den nya modellen är 50% billigare än den tidigare GPT-4 Turbo, vilket gör den mer tillgänglig för API-användare. Den kostnadsfria versionen av ChatGPT använder nu GPT-4 Omni, vilket gör att fler användare kan dra nytta av dess funktioner.

Prissättning och kostnadseffektivitet för GPT-4 Omni

Prissättning och kostnadseffektivitet för GPT-4 Omni

Kundgörelsen av GPT-4 Omni innebär betydande förbättringar i prissättning och kostnadseffektivitet jämfört med tidigare modeller. Några viktiga höjdpunkter:

- Inmatningskostnaden har sjunkit till $0,005 per 1 000 tokens, ner från $0,01 för GPT-4 Turbo.

- Utmatningskostnaden är nu $0,015 per 1 000 tokens, minskad från $0,03 för GPT-4 Turbo.

- Prissättningen för vision är också mycket billigare, vilket gör den totala användningen av GPT-4 Omni mer kostnadseffektiv.

- Jämfört med GPT-3.5 Turbo erbjuder GPT-4 Omni en 50% prisreduktion, vilket gör den till ett mer tillgängligt alternativ för utvecklare och användare.

- Den kostnadsfria versionen av ChatGPT använder nu GPT-4 Omni-modellen, vilket gör att fler användare kan dra nytta av de förbättrade funktionerna och prestandan utan extra kostnad.

Modellvärderingar och benchmarking

Modellvärderingar och benchmarking

Open AI har testat den nya GPT-4 Omni-modellen genom olika referensmätningar för att utvärdera dess prestanda. Modellen jämfördes med andra språkmodeller som GPT-4 Turbo, den ursprungliga GPT-4, Claude 3, Opus Gemini Pro 1.5, Gemini 1.0 och LLaMA 3.

Resultaten visar att GPT-4 Omni överträffar nästan varje annan modell i olika testområden:

- Textutvärdering: GPT-4 Omni uppnår de högsta resultaten.

- Ljud-ASR (automatisk talidentifiering): GPT-4 Omni överträffar den tidigare Whisper version 3-modellen, med lägre felfrekvens.

- Ljudöversättning: GPT-4 Omni slår alla andra modeller i detta test.

- M3 Exam Zero-Shot: GPT-4 Omni överträffar den ursprungliga GPT-4-modellen.

- Utvärderingar av visuell förståelse: GPT-4 Omni uppnår de högsta resultaten på varje test.

Språktokenisering och representation

Språktokenisering och representation

Artikel noterar att en av anledningarna till att GPT-4 Omni är billigare är dess förmåga att representera språk med färre tokens. Även om tokenantalet för engelska endast har minskat med 1,1 gånger, kan detta resultera i betydande kostnadsbesparingar när det skalas upp över stora mängder text.

Artikel förklarar att den fullständiga mening som tidigare tog 27 tokens nu endast tar 24 tokens. Denna förbättrade språkmodellering och representation gör det möjligt för GPT-4 Omni att vara mer effektiv i sin användning av tokens, vilket leder till 50% lägre kostnad jämfört med tidigare modeller.

Artikel antyder att denna förbättrade språkmodellering är en nyckelkomponent i att göra GPT-4 Omni till ett mer kostnadseffektivt val för utvecklare och användare, särskilt för applikationer som involverar bearbetning av stora volymer text över flera språk.

Säkerhet och begränsningar för GPT-4 Omni

Säkerhet och begränsningar för GPT-4 Omni

Liksom alla deras AI-modeller är OpenAI mycket fokuserade på säkerheten och begränsningarna hos GPT-4 Omni. Artikeln noterar att modellen fortfarande har vissa begränsningar, såsom att ibland avbryta konversationer och behöva manuellt informeras när användaren är klar med att prata. Detta är ett problem som har kvarstått även med de förbättrade svarstiderna hos GPT-4 Omni.

Artikel nämner också att modellen har inbyggda säkerhetsfunktioner och begränsningar för att hantera potentiell missbruk eller skadliga utdata. De specifika detaljerna kring dessa säkerhetsåtgärder anges dock inte i detta avsnitt.

Sammanfattningsvis, även om GPT-4 Omni representerar ett betydande framsteg i OpenAI:s språkmodeller, förblir företaget försiktigt och vakande när det gäller de potentiella riskerna och begränsningarna hos tekniken. Kontinuerlig övervakning och förfining av modellens säkerhetsfunktioner kommer sannolikt att vara en prioritet när den distribueras mer brett.

Tillgänglighet och åtkomst till GPT-4 Omni

Tillgänglighet och åtkomst till GPT-4 Omni

GPT-4 Omni, den senaste flaggskeppsmodellen från OpenAI, är nu brett tillgänglig för användare. Här är de viktigaste detaljerna:

- GPT-4 Omni text- och bildmodeller är nu integrerade i den kostnadsfria versionen av ChatGPT, vilket gör att alla användare kan komma åt dessa funktioner.

- Den kostnadsfria versionen av ChatGPT har nu 5 gånger högre meddelandegränser, vilket gör den mycket mer tillgänglig för användare.

- En ny version av röstläge med GPT-4 Omni-integrering planeras att lanseras om ett par veckor, vilket ger sömlösa ljudbaserade interaktioner.

- GPT-4 Omni finns tillgänglig som en fristående text- och visionsmodell via OpenAI-API:et, vilket erbjuder utvecklare dubbla hastigheten och halva priset jämfört med den tidigare GPT-4 Turbo-modellen.

- OpenAI uppmuntrar starkt alla utvecklare att byta till GPT-4 Omni-modellen, eftersom den har blivit det rekommenderade valet med i princip inga användningsfall för den äldre GPT-4 Turbo-modellen.

- Prissättningen för GPT-4 Omni har sänkts betydligt, där inmatningskostnaden har sjunkit till $0,005 per 1 000 tokens och utmatningskostnaden är $0,015 per 1 000 tokens, vilket gör den mer tillgänglig för en bred uppsättning av tillämpningar.

Konsekvent karaktärsskapande med GPT-4 Omni

Konsekvent karaktärsskapande med GPT-4 Omni

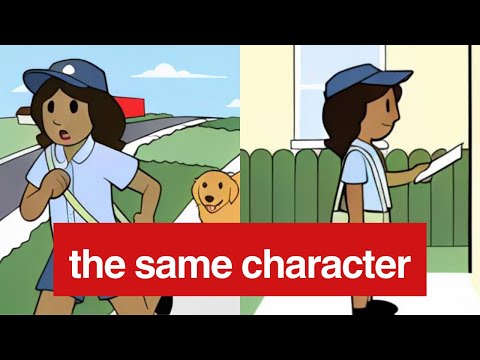

Förmågan att skapa konsekventa karaktärer över flera scener är en nyckelkapacitet hos den nya GPT-4 Omni-modellen. Genom att tränas på visuella indata kan modellen nu generera visuella utdata som bibehåller samma karaktärsattribut, såsom kläder, accessoarer och poser, även när karaktären placeras i olika scenarier.

I de exempel som ges kan modellen konsekvent avbilda karaktären "Sally" som en leende postutdelare, där hennes väska och uniform förblir desamma över olika scener. Detta är en betydande förbättring jämfört med tidigare modeller, som skulle behöva förlita sig på textuella beskrivningar för att försöka upprätthålla karaktärskonsistens.

GPT-4 Omnis hastighet och noggrannhet i visuella utdata möjliggör också smidigare och naturligare interaktioner, där modellen snabbt kan svara på visuella prompter och generera lämpliga visuella svar. Detta öppnar upp nya möjligheter för applikationer som kräver konsekvent karaktärsrepresentation, såsom interaktiv berättande, virtuella assistenter och till och med spelutveckling.

Medan exemplen inom ChatGPT-gränssnittet kanske inte fullt ut visar modellens kapacitet, är potentialen för konsekvent karaktärsskapande med GPT-4 Omni tydlig. Utvecklare kan utnyttja denna funktion för att skapa mer engagerande och immersiva upplevelser för användare, och vidare utforska möjligheterna med multimodala AI-system.

Slutsats

Slutsats

Den nya GPT-4 Omni-modellen från OpenAI är ett betydande framsteg inom naturlig språkbehandling, som kombinerar text, ljud och visuella indata för att tillhandahålla realtidsinteraktioner som liknar mänskliga. Modellens imponerande prestanda över olika referensmätningar, samt dess minskade kostnad och ökade tillgänglighet, gör den till ett övertygande val för utvecklare och användare.

Dock belyser författarens utforskning av modellens förmåga att upprätthålla konsekventa karaktärsrepresentationer över flera scener de pågående utmaningarna på detta område. Medan exemplen som ges i tillkännagivandeartikel tyder på att modellen kan bevara visuella detaljer, antyder författarens egna experiment inom ChatGPT-gränssnittet att denna förmåga kanske inte är lika robust som påstått.

Autorens förslag att testa modellens karaktärskonsistens via API:et snarare än ChatGPT-gränssnittet är ett giltigt förslag, eftersom det senare kan vara föremål för ytterligare säkerhets- och moderationsrestriktioner som kan påverka modellens prestanda. I slutändan kommer ytterligare testning och experiment att krävas för att fullt ut förstå omfattningen av modellens kapacitet på detta område.

Sammanfattningsvis representerar lanseringen av GPT-4 Omni ett spännande steg framåt inom multimodal AI, och författarens insikter ger en värdefull perspektiv på både modellens styrkor och de områden som kan kräva ytterligare förfining.

FAQ

FAQ