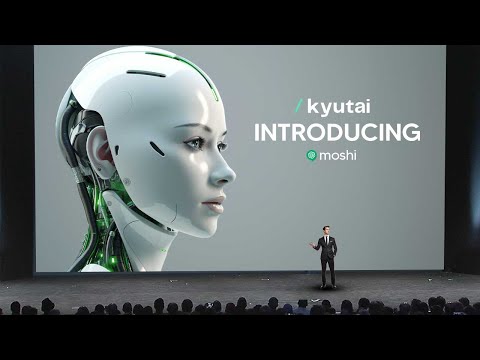

Kyutai's baanbrekende VOICE AI-model herdefiniëert conversationele AI

Kyutai's baanbrekende VOICE AI-model, Moshi, herdefiniëert conversationele AI met zijn vermogen om meer dan 70 emoties, spreekstijlen en meertalige mogelijkheden uit te drukken. Dit multimodale en multistream AI-framework duwt de grenzen van real-time interacties op, waarbij een naadloze en mensachtige conversatie-ervaring wordt geboden.

22 april 2025

Ontdek de toekomst van AI-aangedreven gesprekken met de baanbrekende "VOICE AI"-technologie van Kyutai. Dit state-of-the-art model biedt levensechte interacties, naadloze multimodale mogelijkheden en ongekende emotionele expressie, waardoor de manier waarop we omgaan met AI-assistenten opnieuw wordt gedefinieerd.

Moshi's Indrukwekkende Mogelijkheden: Van Emoties tot Accenten

Het Overwinnen van de Beperkingen van Huidige Spraak-AI Benaderingen

Doorbraken in de Ontwikkeling van Moshi: Multimodaliteit, Multistream en Aanpassingsvermogen

Moshi's TTS-Engine en Spraaksynthese

Moshi Trainen: Van Alleen-Tekst naar Conversatie-AI

Moshi Lokaal Draaien op een Apparaat

AI-Veiligheid Waarborgen met Moshi

Conclusie

Moshi's Indrukwekkende Mogelijkheden: Van Emoties tot Accenten

Moshi's Indrukwekkende Mogelijkheden: Van Emoties tot Accenten

Moshi is een opmerkelijk AI-model dat een breed scala aan emoties en sprekende stijlen kan uitdrukken. Zijn mogelijkheden zijn echt indrukwekkend:

- Moshi kan met meer dan 70 verschillende emoties spreken, van fluisteren tot doodsbang klinken, en kan zelfs een piraat nadoen of met een Frans accent spreken.

- Het model kan in real-time reageren, natuurlijke gesprekken voeren en zijn toon en taal aanpassen aan de situatie.

- De text-to-speech-engine van Moshi is zeer geavanceerd en genereert levensechte audio die emotie en persoonlijkheid naadloos combineert.

- Het model is getraind op een diverse dataset, waardoor het een verscheidenheid aan onderwerpen en taken aan kan, van het opzeggen van poëzie tot het bespreken van actuele gebeurtenissen.

- De multimodale aard van Moshi, waarbij audio- en tekstuele outputs worden gecombineerd, verbetert zijn vermogen om effectief te communiceren en uitgebreide antwoorden te geven.

- De indrukwekkende prestaties van het model zijn bereikt door innovatieve trainingtechnieken, waaronder het gebruik van synthetische dialogen om Moshi's conversatievaardigheden te verfijnen.

Het Overwinnen van de Beperkingen van Huidige Spraak-AI Benaderingen

Het Overwinnen van de Beperkingen van Huidige Spraak-AI Benaderingen

De huidige benaderingen van voice-AI hebben twee hoofdbeperkingen die CAAI moest aanpakken bij de ontwikkeling van Moshi:

-

Latentie: De complexe pijplijn van afzonderlijke modellen veroorzaakt een latentie van 3-5 seconden tussen de invoer van de gebruiker en de reactie van het systeem. Dit kan zeer irritant zijn voor een live conversatie-ervaring.

-

Verlies van niet-tekstuele informatie: Door een tekstgebaseerde bottleneck te gebruiken, verliest het systeem alle niet-tekstuele informatie zoals emotie, toon en communicatieve signalen die aanwezig zijn in de oorspronkelijke spraak.

Om deze beperkingen aan te pakken, heeft CAAI een andere aanpak gekozen. In plaats van een complexe pijplijn van afzonderlijke modellen te gebruiken, hebben ze een enkele diepe neurale netwerk-gebaseerde "audio language model" ontworpen. Dit model wordt rechtstreeks getraind op geannoteerde spraakgegevens, zonder de tussenliggende tekstrepresentatie.

Door de spraak-input te comprimeren tot een compact "pseudo-woord"-representatie, kan het audio language model de patronen en structuur van spraak leren, net zoals teksttaalmodellen leren van tekst. Hierdoor kan het model reacties genereren die de rijkdom van de oorspronkelijke spraak behouden, zonder de latentie die wordt geïntroduceerd door de tekstgebaseerde aanpak.

Het resultaat is een natuurlijkere, laag-latente conversatie-ervaring die de volledige expressiviteit van menselijke spraak vastlegt.

Doorbraken in de Ontwikkeling van Moshi: Multimodaliteit, Multistream en Aanpassingsvermogen

Doorbraken in de Ontwikkeling van Moshi: Multimodaliteit, Multistream en Aanpassingsvermogen

De belangrijkste doorbraken in de ontwikkeling van Moshi, het geavanceerde conversatie-AI-model, zijn:

-

Multimodaliteit: Moshi kan niet alleen luisteren en audio genereren, maar heeft ook tekstuele gedachten die tijdens het gesprek op het scherm worden weergegeven. Hierdoor kan het de efficiëntie en compactheid van geschreven tekst combineren met de rijkdom van audio om betere en snellere reacties te geven.

-

Multistream: Moshi werkt met twee parallelle audio-streams, waardoor het tegelijkertijd kan spreken en luisteren. Dit maakt natuurlijkere gesprekken mogelijk met overlappende spraak, onderbrekingen en een naadloze heen-en-weer, waardoor de interactie menselijker aanvoelt.

-

Aanpassingsvermogen: Moshi is niet alleen een conversationeel spraak-AI-model, maar een flexibel raamwerk dat kan worden aangepast aan verschillende taken en toepassingen. Het team heeft Moshi's vermogen gedemonstreerd om een discussie uit de jaren 90/2000 aan te gaan, waarmee het de veelzijdigheid en het potentieel om met gegevens uit verschillende tijdsperiodes te interageren, toont.

Moshi's TTS-Engine en Spraaksynthese

Moshi's TTS-Engine en Spraaksynthese

Een van de meest verbazingwekkende dingen over Moshi is dat het niet zomaar een soort AI-model is, maar een text-to-speech-engine met meer dan 70 verschillende emoties die kunnen worden gebruikt. Met behulp van de opgenomen gegevens kon het team een text-to-speech-engine trainen die meer dan 70 verschillende emoties of sprekende stijlen kan ondersteunen.

Om de mogelijkheden van deze TTS-engine te demonstreren, speelde het team enkele gegenereerde audio-samples af. De samples toonden Moshi's vermogen om een breed scala aan emoties uit te drukken, van fluisteren tot zingen, en zelfs het nadoen van een piraat of het spreken met een Frans accent. Dit toont de indrukwekkende veelzijdigheid en levensechte kwaliteit van Moshi's spraaksynthese-mogelijkheden.

Het team legde uit dat deze TTS-engine intern is ontwikkeld, waardoor ze deze specifiek voor Moshi's behoeften konden afstemmen. Door samen te werken met een stemactrice genaamd Alice, konden ze verschillende monologen en dialogen opnemen, die vervolgens werden gebruikt om het text-to-speech-model te trainen. Deze aanpak zorgt ervoor dat Moshi een consistente en natuurlijk klinkende stem heeft in alle interacties.

Moshi Trainen: Van Alleen-Tekst naar Conversatie-AI

Moshi Trainen: Van Alleen-Tekst naar Conversatie-AI

De belangrijkste doorbraken bij het trainen van Moshi, het geavanceerde conversatie-AI-model, kunnen als volgt worden samengevat:

-

Multimodaliteit: Moshi kan niet alleen audio genereren, maar ook bijbehorende tekstuele gedachten produceren. Deze hybride aanpak van het combineren van audio en tekst maakt efficiëntere en effectievere training mogelijk, wat leidt tot betere reacties.

-

Multistream-interactie: Moshi is in staat om tegelijkertijd te luisteren en te spreken, waardoor een natuurlijke conversatiestroom met overlappende spraak, onderbrekingen en naadloze heen-en-weer mogelijk is, net als bij menselijke gesprekken.

-

Generatie van synthetische gegevens: Om het probleem van beperkte real-world conversatiegegevens op te lossen, heeft het team technieken ontwikkeld om synthetische dialogen te genereren. Dit stelde hen in staat om Moshi's conversatievaardigheden verder te verfijnen, voorbij het initiële tekstgebaseerde taalmodel.

-

Stemcustomisatie: Door samen te werken met een professionele stemactrice, Alice, kon het team Moshi voorzien van een consistente en natuurlijk klinkende stem in alle interacties, wat de gebruikerservaring verder verbetert.

-

On-device-implementatie: Het Moshi-model is ontworpen om relatief klein van omvang te zijn, waardoor het rechtstreeks op apparaten kan worden geïmplementeerd en uitgevoerd, wat privacy en lage latentie reacties mogelijk maakt zonder de noodzaak van cloud-connectiviteit.

-

Veiligheidskwesties: Erkennend het potentieel voor misbruik, heeft het team beveiligingsmaatregelen geïmplementeerd, zoals audio-watermerkingen en handtekeningtracking, om de generatie van Moshi-achtige inhoud voor kwaadwillige doeleinden te detecteren en te beperken.

Moshi Lokaal Draaien op een Apparaat

Moshi Lokaal Draaien op een Apparaat

Een van de belangrijkste doorbraken met Moshi is zijn vermogen om lokaal op een apparaat te draaien, zonder een internetverbinding nodig te hebben. Dit is een belangrijke vooruitgang, omdat het problemen met privacy en latentie aanpakt die eerdere voice-AI-systemen hebben geteisterd.

Het team bij CAAI demonstreerde deze mogelijkheid door Moshi op een standaard MacBook Pro te laten draaien, met de internetverbinding uitgeschakeld. Ze lanceerden de Moshi-applicatie en konden een real-time gesprek voeren met de AI-assistent, zonder merkbare vertraging of vertraging.

Deze on-device-uitvoering is mogelijk gemaakt door de relatief kleine omvang van het Moshi-model, waarvan het team benadrukte dat het verder kan worden samengedrukt voor implementatie op mobiele apparaten. Door het model lokaal uit te voeren, kan Moshi een naadlozere en privacyvriendelijkere conversatie-ervaring bieden, zonder de noodzaak om audio-gegevens naar een externe server te sturen.

Het team besprak ook het belang van veiligheid en verantwoorde ontwikkeling van dergelijke geavanceerde AI-systemen. Ze schetsten twee belangrijke strategieën om de integriteit van door Moshi gegenereerde inhoud te waarborgen: online handtekeningtracking en watermerkering. Deze technieken maken het mogelijk om audio die door AI is gegenereerd te detecteren, waardoor potentieel misbruik van de technologie kan worden beperkt.

AI-Veiligheid Waarborgen met Moshi

AI-Veiligheid Waarborgen met Moshi

Een van de laatste dingen waar de meeste mensen niet aan denken, is natuurlijk het aspect van AI-veiligheid. Als je een model hebt dat zo snel is en met een opmerkelijke nauwkeurigheid kan reageren, weten we dat mensen dit potentieel kunnen gebruiken voor phishingcampagnes of andere kwaadaardige activiteiten. Hier beschrijven ze hoe ze Moshi-inhoud veilig zullen identificeren en ervoor zullen zorgen dat dit geen wijdverbreid probleem wordt.

Hallo, ik ben van qAI. We nemen veiligheid zeer serieus. Een vraag die we in het bijzonder willen beantwoorden, is hoe te bepalen of een audio door Moshi is gegenereerd of niet. Hiervoor hebben we twee strategieën overwogen:

-

Online aanpak: We houden bij welke audio Moshi genereert door enkele handtekeningen te extraheren en deze in een database van gegenereerde inhoud op te nemen. Wanneer we met nieuwe audio worden geconfronteerd, kunnen we een handtekening extraheren en controleren of deze overeenkomt met de database. Als dat zo is, weten we dat de audio door Moshi is gegenereerd.

-

Watermerkering: We voegen enkele onhoorbare markeringen toe aan de audio die we genereren, zodat we ze met een specifieke detector kunnen detecteren. Hiermee kunnen we Moshi-gegenereerde inhoud identificeren.

Dit zijn actieve onderzoeksgebieden die belangrijk, uitdagend en interessant zijn. We zijn vastbesloten om de veilige en verantwoorde ontwikkeling van Moshi te waarborgen om misbruik of kwaadaardige activiteiten te voorkomen.

FAQ

FAQ