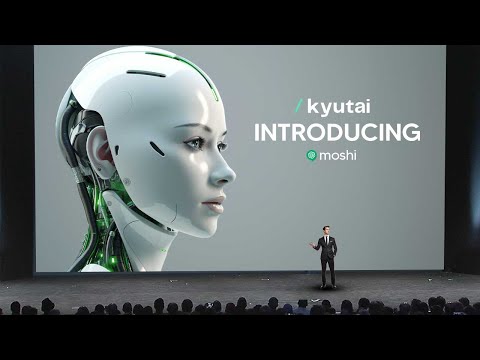

Il modello rivoluzionario di VOICE AI di Kyutai ridefinisce l'AI conversazionale

Il modello rivoluzionario di VOICE AI di Kyutai, Moshi, ridefinisce l'AI conversazionale con la sua capacità di esprimere oltre 70 emozioni, stili di parlata e capacità multilingue. Questo framework di AI multimodale e multistream spinge i confini delle interazioni in tempo reale, offrendo un'esperienza conversazionale fluida e simile all'umano.

6 aprile 2025

Scopri il futuro delle conversazioni alimentate dall'IA con la tecnologia rivoluzionaria "VOICE AI" di Kyutai. Questo modello all'avanguardia offre interazioni realistiche, capacità multimodali senza soluzione di continuità e un'espressione emotiva senza pari, ridefinendo il modo in cui interagiamo con gli assistenti IA.

Le impressionanti capacità di Moshi: dalle emozioni agli accenti

Superare i limiti degli approcci attuali all'intelligenza vocale artificiale

Progressi nello sviluppo di Moshi: multimodalità, multistream e adattabilità

Il motore TTS di Moshi e la sintesi vocale

Addestrare Moshi: dall'unico testo all'intelligenza artificiale conversazionale

Eseguire Moshi localmente sul dispositivo

Garantire la sicurezza dell'intelligenza artificiale con Moshi

Conclusione

Le impressionanti capacità di Moshi: dalle emozioni agli accenti

Le impressionanti capacità di Moshi: dalle emozioni agli accenti

Moshi è un modello di AI straordinario in grado di esprimere una vasta gamma di emozioni e stili di comunicazione. Le sue capacità sono davvero impressionanti:

- Moshi può parlare con oltre 70 diverse emozioni, dal sussurro al terrore, e può persino impersonare un pirata o parlare con accento francese.

- Il modello è in grado di rispondere in tempo reale, impegnandosi in conversazioni naturali e adattando il tono e il linguaggio alla situazione.

- Il motore di sintesi vocale di Moshi è altamente avanzato, generando audio realistico che fonde perfettamente emozione e personalità.

- Il modello è stato addestrato su un dataset diversificato, permettendogli di gestire una varietà di argomenti e compiti, dalla recitazione di poesie alla discussione di eventi attuali.

- La natura multimodale di Moshi, che combina output audio e testuali, ne potenzia la capacità di comunicare in modo efficace e fornire risposte complete.

- Le impressionanti prestazioni del modello sono state ottenute attraverso tecniche di addestramento innovative, tra cui l'utilizzo di dialoghi sintetici per perfezionare le capacità conversazionali di Moshi.

Complessivamente, Moshi rappresenta una svolta significativa nell'ambito dell'AI conversazionale, fissando un nuovo standard per interazioni naturali, coinvolgenti ed emotivamente espressive.

Superare i limiti degli approcci attuali all'intelligenza vocale artificiale

Superare i limiti degli approcci attuali all'intelligenza vocale artificiale

Gli approcci attuali all'AI vocale presentano due principali limitazioni che CAAI ha dovuto affrontare nello sviluppo di Moshi:

-

Latenza: La complessa pipeline di modelli separati induce una latenza di 3-5 secondi tra l'input dell'utente e la risposta del sistema. Ciò può essere estremamente fastidioso per un'esperienza conversazionale dal vivo.

-

Perdita di informazioni non testuali: Passando attraverso un collo di bottiglia basato sul testo, il sistema perde tutte le informazioni non testuali come emozione, tono e segnali di comunicazione presenti nel discorso originale.

Per affrontare queste limitazioni, CAAI ha adottato un approccio diverso. Invece di utilizzare una complessa pipeline di modelli separati, hanno progettato un singolo "modello di linguaggio audio" basato su una rete neurale profonda. Questo modello viene addestrato direttamente su dati di discorso annotati, senza la rappresentazione intermedia del testo.

Comprimendo l'input audio in una rappresentazione compatta di "pseudo-parole", il modello di linguaggio audio può apprendere i modelli e la struttura del discorso, in modo simile a come i modelli di linguaggio del testo apprendono dal testo. Ciò consente al modello di generare risposte che preservano la ricchezza del discorso originale, senza la latenza introdotta dall'approccio basato sul testo.

Il risultato è un'esperienza conversazionale più naturale e a bassa latenza che cattura l'intera espressività del discorso umano.

Progressi nello sviluppo di Moshi: multimodalità, multistream e adattabilità

Progressi nello sviluppo di Moshi: multimodalità, multistream e adattabilità

I principali progressi nello sviluppo di Moshi, il modello di AI conversazionale avanzato, sono:

-

Multimodalità: Moshi non solo può ascoltare e generare audio, ma ha anche pensieri testuali visualizzati sullo schermo durante la conversazione. Ciò gli consente di sfruttare l'efficienza e la compattezza del testo scritto insieme alla ricchezza dell'audio per fornire risposte migliori e più rapide.

-

Flusso multiplo: Moshi opera con due flussi audio paralleli, consentendogli di parlare e ascoltare simultaneamente. Questo permette conversazioni più naturali con sovrapposizioni di discorso, interruzioni e uno scambio fluido, rendendo l'interazione più simile a quella umana.

-

Adattabilità: Moshi non è solo un modello di AI conversazionale, ma un framework flessibile che può essere adattato a vari compiti e casi d'uso. Il team ha dimostrato la capacità di Moshi di impegnarsi in una discussione degli anni '90/2000, evidenziando la sua versatilità e il potenziale di interagire con dati di diversi periodi.

Questi progressi chiave, realizzati dal team di Moshi in soli 6 mesi con un piccolo team di 8 persone, hanno permesso la creazione di un sistema di AI conversazionale altamente realistico e reattivo, in grado di offrire un'esperienza di interazione davvero immersiva e naturale.

Il motore TTS di Moshi e la sintesi vocale

Il motore TTS di Moshi e la sintesi vocale

Una delle cose più sorprendenti di Moshi è che non si tratta solo di un modello di AI, ma di un motore di sintesi vocale che dispone di oltre 70 diverse emozioni accessibili. Utilizzando i dati registrati, il team è stato in grado di addestrare un motore di sintesi vocale in grado di supportare più di 70 diverse emozioni o stili di comunicazione.

Per mostrare le capacità di questo motore di sintesi vocale, il team ha riprodotto alcuni campioni audio generati. I campioni hanno dimostrato la capacità di Moshi di esprimere un'ampia gamma di emozioni, dal sussurro al canto, e persino di impersonare un pirata o parlare con accento francese. Ciò mette in luce l'impressionante versatilità e la qualità realistica della sintesi vocale di Moshi.

Il team ha spiegato che questo motore di sintesi vocale è stato sviluppato internamente, consentendo loro di perfezionarlo specificamente per le esigenze di Moshi. Lavorando con un'artista vocale di nome Alice, sono riusciti a registrare vari monologhi e dialoghi, che sono stati poi utilizzati per addestrare il modello di sintesi vocale. Questo approccio garantisce che Moshi abbia una voce coerente e naturale in tutte le interazioni.

Complessivamente, il motore di sintesi vocale di Moshi è un risultato straordinario, che dimostra la capacità del team di spingere i limiti di ciò che è possibile nella sintesi vocale e nell'espressione emotiva. Questa capacità, combinata con gli altri progressi di Moshi, è ciò che rende questo modello davvero rivoluzionario e destinato a cambiare il panorama dell'AI conversazionale.

Addestrare Moshi: dall'unico testo all'intelligenza artificiale conversazionale

Addestrare Moshi: dall'unico testo all'intelligenza artificiale conversazionale

I principali progressi nell'addestramento di Moshi, il modello di AI conversazionale avanzato, possono essere riassunti come segue:

-

Multimodalità: Moshi non solo può generare audio, ma può anche produrre pensieri testuali accompagnanti. Questo approccio ibrido che combina audio e testo consente un addestramento più efficiente ed efficace, portando a risposte migliori.

-

Interazione a flusso multiplo: Moshi è in grado di ascoltare e parlare simultaneamente, consentendo un flusso conversazionale naturale con sovrapposizioni di discorso, interruzioni e uno scambio fluido, proprio come nelle conversazioni umane.

-

Generazione di dati sintetici: Per superare la sfida dei limitati dati conversazionali del mondo reale, il team ha sviluppato tecniche per generare dialoghi sintetici. Ciò ha permesso loro di perfezionare ulteriormente le capacità conversazionali di Moshi oltre il modello di linguaggio iniziale basato solo sul testo.

-

Personalizzazione della voce: Lavorando con un'artista vocale professionista, Alice, il team è riuscito a dotare Moshi di una voce coerente e naturale in tutte le interazioni, migliorando ulteriormente l'esperienza dell'utente.

-

Distribuzione on-device: Il modello Moshi è progettato per essere relativamente di piccole dimensioni, consentendone la distribuzione e l'esecuzione direttamente sui dispositivi, garantendo la privacy e risposte a bassa latenza senza la necessità di connettività cloud.

-

Considerazioni sulla sicurezza: Riconoscendo il potenziale di uso improprio, il team ha implementato salvaguardie, come il watermarking audio e il tracciamento delle firme, per rilevare e mitigare la generazione di contenuti simili a Moshi per scopi dannosi.

Questi progressi nell'addestramento e nella distribuzione hanno permesso a Moshi di raggiungere un livello straordinario di capacità conversazionale, fondendo in modo armonioso audio, testo e interazione multimodale per offrire un'esperienza utente davvero immersiva e naturale.

Eseguire Moshi localmente sul dispositivo

Eseguire Moshi localmente sul dispositivo

Uno dei principali progressi con Moshi è la sua capacità di funzionare localmente su un dispositivo, senza richiedere una connessione Internet. Questo è un notevole avanzamento, in quanto affronta le preoccupazioni relative alla privacy e alla latenza che hanno afflitto i precedenti sistemi di AI vocale.

Il team di CAAI ha dimostrato questa capacità eseguendo Moshi su un comune MacBook Pro, con la connessione Internet disattivata. Hanno lanciato l'applicazione Moshi e sono stati in grado di impegnarsi in una conversazione in tempo reale con l'assistente AI, senza alcun ritardo o latenza apprezzabile.

Questa esecuzione on-device è resa possibile dalle dimensioni relativamente ridotte del modello Moshi, che il team ha sottolineato poter essere ulteriormente compresse per la distribuzione su dispositivi mobili. Eseguendo il modello localmente, Moshi può fornire un'esperienza conversazionale più fluida e privata, senza la necessità di inviare dati audio a un server remoto.

Il team ha anche discusso dell'importanza della sicurezza e dello sviluppo responsabile di tali sistemi di AI avanzati. Hanno delineato due strategie chiave per garantire l'integrità dei contenuti generati da Moshi: il tracciamento delle firme online e il watermarking. Queste tecniche consentono il rilevamento di audio generato dall'AI, contribuendo a mitigare il potenziale uso improprio della tecnologia.

Complessivamente, la capacità di eseguire Moshi localmente su un dispositivo è un traguardo significativo, che dimostra l'impegno del team nel fornire un assistente AI conversazionale ad alte prestazioni e rispettoso della privacy. Questo progresso apre la strada a una più ampia adozione e integrazione di Moshi in varie applicazioni e casi d'uso.

Garantire la sicurezza dell'intelligenza artificiale con Moshi

Garantire la sicurezza dell'intelligenza artificiale con Moshi

Una delle ultime cose a cui la maggior parte delle persone non pensa è ovviamente l'aspetto della sicurezza dell'AI. Se si dispone di un modello così rapido e in grado di rispondere con un grado di precisione notevole, sappiamo che le persone potrebbero potenzialmente utilizzarlo per campagne di phishing o altre attività dannose. Ecco dove descrivono come intendono identificare in modo sicuro i contenuti di Moshi e assicurarsi che non si tratti di un problema diffuso.

Ciao, sono di qAI. Siamo molto seri riguardo alla sicurezza. Una domanda in particolare a cui vogliamo rispondere è come determinare se un audio sia stato generato da Moshi o meno. Per questo, abbiamo considerato due strategie:

-

Approccio online: Teniamo traccia degli audio generati da Moshi estraendo alcune firme e inserendole in un database dei contenuti generati. Quando viene presentato un nuovo audio, possiamo estrarre una firma e verificare se corrisponde al database. In tal caso, sappiamo che l'audio è stato generato da Moshi.

-

Watermarking: Aggiungiamo alcuni segni inudibili agli audio che generiamo, in modo da poterli rilevare con uno specifico rilevatore. Ciò ci consente di identificare i contenuti generati da Moshi.

Queste sono aree di ricerca attive che sono importanti, impegnative e interessanti. Siamo impegnati a garantire lo sviluppo sicuro e responsabile di Moshi per prevenire qualsiasi uso improprio o attività dannosa.

FAQ

FAQ