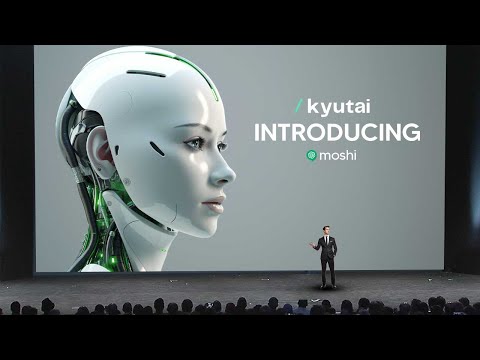

Le modèle d'IA vocale révolutionnaire de Kyutai redéfinit l'IA conversationnelle

Le modèle d'IA vocale révolutionnaire de Kyutai, Moshi, redéfinit l'IA conversationnelle avec sa capacité à exprimer plus de 70 émotions, styles de parole et capacités multilingues. Ce cadre d'IA multimodal et multistream repousse les limites des interactions en temps réel, offrant une expérience de conversation fluide et humaine.

23 avril 2025

Découvrez l'avenir des conversations alimentées par l'IA avec la technologie révolutionnaire "VOICE AI" de Kyutai. Ce modèle de pointe offre des interactions réalistes, des capacités multimodales fluides et une expression émotionnelle sans précédent, redéfinissant la façon dont nous interagissons avec les assistants IA.

Les impressionnantes capacités de Moshi : des émotions aux accents

Surmonter les limites des approches actuelles de l'IA vocale

Percées dans le développement de Moshi : multimodalité, multiflux et adaptabilité

Le moteur TTS de Moshi et la synthèse vocale

Former Moshi : du texte seul à l'IA conversationnelle

Exécuter Moshi localement sur un appareil

Assurer la sécurité de l'IA avec Moshi

Conclusion

Les impressionnantes capacités de Moshi : des émotions aux accents

Les impressionnantes capacités de Moshi : des émotions aux accents

Moshi est un modèle d'IA remarquable qui peut exprimer une large gamme d'émotions et de styles de parole. Ses capacités sont vraiment impressionnantes :

- Moshi peut parler avec plus de 70 émotions différentes, du chuchotement à la terreur, et peut même imiter un pirate ou parler avec un accent français.

- Le modèle est capable de répondre en temps réel, en s'engageant dans des conversations naturelles et en adaptant son ton et son langage à la situation.

- Le moteur de synthèse vocale de Moshi est très avancé, générant un audio réaliste qui mélange harmonieusement émotion et personnalité.

- Le modèle a été entraîné sur un ensemble de données diversifié, lui permettant de traiter une variété de sujets et de tâches, de la récitation de poésie à la discussion d'actualités.

- La nature multimodale de Moshi, combinant sorties audio et textuelles, renforce sa capacité à communiquer efficacement et à fournir des réponses complètes.

- Les performances impressionnantes du modèle ont été obtenues grâce à des techniques d'entraînement innovantes, notamment l'utilisation de dialogues synthétiques pour affiner les capacités conversationnelles de Moshi.

Dans l'ensemble, Moshi représente une avancée significative dans l'IA conversationnelle, établissant une nouvelle norme pour des interactions naturelles, engageantes et émotionnellement expressives.

Surmonter les limites des approches actuelles de l'IA vocale

Surmonter les limites des approches actuelles de l'IA vocale

Les approches actuelles de l'IA vocale présentent deux principales limites que le CAAI a dû résoudre dans le développement de Moshi :

-

Latence : La pipeline complexe de modèles distincts induit une latence de 3 à 5 secondes entre l'entrée de l'utilisateur et la réponse du système. Cela peut être extrêmement agaçant pour une expérience de conversation en direct.

-

Perte d'informations non textuelles : En passant par un goulot d'étranglement textuel, le système perd toutes les informations non textuelles comme l'émotion, le ton et les indices de communication présents dans la parole d'origine.

Pour relever ces défis, le CAAI a adopté une approche différente. Au lieu d'utiliser une pipeline complexe de modèles distincts, ils ont conçu un seul réseau de neurones profond "modèle de langue audio". Ce modèle est entraîné directement sur des données de parole annotées, sans représentation intermédiaire du texte.

En compressant l'entrée audio dans une représentation compacte de "pseudo-mots", le modèle de langue audio peut apprendre les motifs et la structure de la parole, de la même manière que les modèles de langue textuels apprennent à partir du texte. Cela permet au modèle de générer des réponses qui préservent la richesse de la parole d'origine, sans la latence introduite par l'approche basée sur le texte.

Le résultat est une expérience de conversation plus naturelle et à faible latence qui capture toute l'expressivité de la parole humaine.

Percées dans le développement de Moshi : multimodalité, multiflux et adaptabilité

Percées dans le développement de Moshi : multimodalité, multiflux et adaptabilité

Les principales percées dans le développement de Moshi, le modèle d'IA conversationnelle avancé, sont :

-

Multimodalité : Moshi peut non seulement écouter et générer de l'audio, mais il a aussi des pensées textuelles qui s'affichent à l'écran pendant la conversation. Cela lui permet de tirer parti de l'efficacité et de la compacité du texte écrit ainsi que de la richesse de l'audio pour fournir de meilleures réponses plus rapidement.

-

Flux multiple : Moshi fonctionne avec deux flux audio parallèles, lui permettant de parler et d'écouter simultanément. Cela permet des conversations plus naturelles avec des chevauchements de parole, des interruptions et des échanges fluides, rendant l'interaction plus humaine.

-

Adaptabilité : Moshi n'est pas seulement un modèle de parole conversationnelle, mais un cadre flexible qui peut être adapté à diverses tâches et cas d'utilisation. L'équipe a démontré la capacité de Moshi à participer à une discussion des années 1990/2000, illustrant sa polyvalence et le potentiel d'interagir avec des données de différentes périodes.

Ces percées clés, réalisées par l'équipe de Moshi en seulement 6 mois avec une petite équipe de 8 personnes, ont permis la création d'un système d'IA conversationnelle hautement réaliste et réactif qui peut offrir une expérience d'interaction immersive et naturelle.

Le moteur TTS de Moshi et la synthèse vocale

Le moteur TTS de Moshi et la synthèse vocale

L'une des choses les plus étonnantes à propos de Moshi est que ce n'est pas seulement un modèle d'IA, mais plutôt un moteur de synthèse vocale qui dispose de plus de 70 émotions différentes accessibles. En utilisant les données enregistrées, l'équipe a pu entraîner un moteur de synthèse vocale capable de prendre en charge plus de 70 émotions ou styles de parole différents.

Pour démontrer les capacités de ce moteur de synthèse vocale, l'équipe a joué quelques échantillons audio générés. Les échantillons ont démontré la capacité de Moshi à exprimer un large éventail d'émotions, du chuchotement au chant, et même à imiter un pirate ou à parler avec un accent français. Cela illustre l'impressionnante polyvalence et la qualité réaliste des capacités de synthèse vocale de Moshi.

L'équipe a expliqué que ce moteur de synthèse vocale a été développé en interne, leur permettant de le peaufiner spécifiquement pour les besoins de Moshi. En travaillant avec une artiste vocale nommée Alice, ils ont pu enregistrer diverses monologues et dialogues, qui ont ensuite été utilisés pour entraîner le modèle de synthèse vocale. Cette approche garantit que Moshi a une voix cohérente et naturelle dans toutes les interactions.

Former Moshi : du texte seul à l'IA conversationnelle

Former Moshi : du texte seul à l'IA conversationnelle

Les principales percées dans l'entraînement de Moshi, le modèle d'IA conversationnelle avancé, peuvent être résumées comme suit :

-

Multimodalité : Moshi peut non seulement générer de l'audio, mais aussi produire des pensées textuelles accompagnantes. Cette approche hybride combinant audio et texte permet un entraînement plus efficace et efficace, conduisant à de meilleures réponses.

-

Interaction à flux multiple : Moshi est capable d'écouter et de parler simultanément, permettant un flux conversationnel naturel avec des chevauchements de parole, des interruptions et des échanges fluides, comme dans les conversations humaines.

-

Génération de données synthétiques : Pour surmonter le défi du manque de données de conversation réelles, l'équipe a développé des techniques pour générer des dialogues synthétiques. Cela leur a permis d'affiner davantage les capacités conversationnelles de Moshi au-delà du modèle de langue initial basé sur le texte.

-

Personnalisation vocale : En travaillant avec une artiste vocale professionnelle, Alice, l'équipe a pu doter Moshi d'une voix cohérente et naturelle dans toutes les interactions, améliorant encore l'expérience utilisateur.

-

Déploiement sur l'appareil : Le modèle Moshi est conçu pour être relativement petit, permettant son déploiement et son exécution directement sur les appareils, assurant la confidentialité et des réponses à faible latence sans nécessiter de connectivité cloud.

-

Considérations de sécurité : Reconnaissant le potentiel d'utilisation abusive, l'équipe a mis en place des mesures de sauvegarde, comme le filigranage audio et le suivi de signature, pour détecter et atténuer la génération de contenu similaire à Moshi à des fins malveillantes.

Ces avancées dans l'entraînement et le déploiement ont permis à Moshi d'atteindre un niveau remarquable de capacité conversationnelle, combinant harmonieusement audio, texte et interaction multimodale pour offrir une expérience utilisateur véritablement immersive et naturelle.

Exécuter Moshi localement sur un appareil

Exécuter Moshi localement sur un appareil

L'une des principales percées avec Moshi est sa capacité à s'exécuter localement sur un appareil, sans nécessiter de connexion Internet. Il s'agit d'une avancée significative, car elle résout les problèmes de confidentialité et de latence qui ont affecté les précédents systèmes d'IA vocale.

L'équipe du CAAI a démontré cette capacité en exécutant Moshi sur un MacBook Pro standard, avec la connexion Internet désactivée. Ils ont lancé l'application Moshi et ont pu engager une conversation en temps réel avec l'assistant IA, sans aucun délai notable.

Cette exécution locale est rendue possible par la taille relativement petite du modèle Moshi, que l'équipe a souligné pouvoir être encore compressée pour un déploiement sur des appareils mobiles. En exécutant le modèle localement, Moshi peut offrir une expérience de conversation plus fluide et privée, sans avoir à envoyer les données audio à un serveur distant.

L'équipe a également abordé l'importance de la sécurité et du développement responsable de ces systèmes d'IA avancés. Ils ont décrit deux stratégies clés pour assurer l'intégrité du contenu généré par Moshi : le suivi de signature en ligne et le filigranage. Ces techniques permettent de détecter l'audio généré par l'IA, aidant à atténuer l'utilisation potentiellement abusive de la technologie.

Dans l'ensemble, la capacité d'exécuter Moshi localement sur un appareil est une étape importante, démontrant l'engagement de l'équipe à offrir un assistant IA conversationnel haute performance et respectueux de la vie privée. Cette avancée ouvre la voie à une adoption plus large et à l'intégration de Moshi dans diverses applications et cas d'utilisation.

Assurer la sécurité de l'IA avec Moshi

Assurer la sécurité de l'IA avec Moshi

L'un des derniers aspects auxquels la plupart des gens ne pensent pas est bien sûr l'aspect de la sécurité de l'IA. Si vous avez un modèle aussi rapide et capable de répondre avec un degré remarquable de précision, nous savons que les gens pourraient potentiellement l'utiliser pour des campagnes de hameçonnage ou d'autres activités malveillantes. C'est là que l'on décrit comment ils vont identifier de manière sûre le contenu de Moshi et s'assurer que ce n'est pas un problème généralisé.

Bonjour, je suis de qAI. Nous sommes très sérieux en matière de sécurité. Une question en particulier que nous voulons aborder est comment déterminer si un audio a été généré par Moshi ou non. Pour cela, nous avons envisagé deux stratégies :

-

Approche en ligne : Nous gardons une trace des audios générés par Moshi en extrayant certaines signatures et en les plaçant dans une base de données de contenu généré. Lorsqu'on nous présente un nouvel audio, nous pouvons en extraire une signature et vérifier si elle correspond à la base de données. Si c'est le cas, nous savons que l'audio est généré par Moshi.

-

Filigranage : Nous ajoutons des marques inaudibles à l'audio que nous générons, de sorte que nous puissions les détecter avec un détecteur spécifique. Cela nous permet d'identifier le contenu généré par Moshi.

Ce sont des domaines de recherche actifs qui sont importants, stimulants et intéressants. Nous nous engageons à assurer le développement sûr et responsable de Moshi pour prévenir toute utilisation abusive ou activité malveillante.

FAQ

FAQ