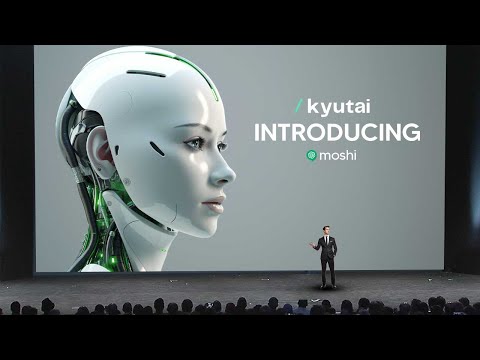

El modelo de IA de voz revolucionario de Kyutai redefine la IA conversacional

El revolucionario modelo de IA de voz de Kyutai, Moshi, redefine la IA conversacional con su capacidad para expresar más de 70 emociones, estilos de habla y capacidades multilingües. Este marco de IA multimodal y de múltiples flujos impulsa los límites de las interacciones en tiempo real, ofreciendo una experiencia conversacional fluida y humana.

23 de febrero de 2025

Descubre el futuro de las conversaciones impulsadas por IA con la tecnología revolucionaria de "VOICE AI" de Kyutai. Este modelo de vanguardia ofrece interacciones realistas, capacidades multimodales fluidas y una expresión emocional sin precedentes, redefiniendo la forma en que nos relacionamos con los asistentes de IA.

Las impresionantes capacidades de Moshi: de las emociones a los acentos

Superando las limitaciones de los enfoques actuales de voz IA

Avances en el desarrollo de Moshi: multimodalidad, multistream y adaptabilidad

El motor TTS de Moshi y la síntesis de voz

Entrenando a Moshi: de texto a IA conversacional

Ejecutando a Moshi localmente en el dispositivo

Garantizando la seguridad de la IA con Moshi

Conclusión

Las impresionantes capacidades de Moshi: de las emociones a los acentos

Las impresionantes capacidades de Moshi: de las emociones a los acentos

Moshi es un modelo de IA notable que puede expresar una amplia gama de emociones y estilos de habla. Sus capacidades son verdaderamente impresionantes:

- Moshi puede hablar con más de 70 emociones diferentes, desde susurrar hasta sonar aterrorizado, e incluso puede imitar a un pirata o hablar con acento francés.

- El modelo puede responder en tiempo real, participando en conversaciones naturales y adaptando su tono y lenguaje a la situación.

- El motor de texto a voz de Moshi es muy avanzado, generando audio realista que combina a la perfección emoción y personalidad.

- El modelo se entrenó con un conjunto de datos diverso, lo que le permite manejar una variedad de temas y tareas, desde recitar poesía hasta discutir eventos actuales.

- La naturaleza multimodal de Moshi, que combina salidas de audio y texto, mejora su capacidad para comunicarse de manera efectiva y proporcionar respuestas completas.

- El impresionante rendimiento del modelo se logró a través de técnicas de entrenamiento innovadoras, incluido el uso de diálogos sintéticos para perfeccionar las habilidades conversacionales de Moshi.

En general, Moshi representa un avance significativo en la IA conversacional, estableciendo un nuevo estándar para interacciones naturales, atractivas y emocionalmente expresivas.

Superando las limitaciones de los enfoques actuales de voz IA

Superando las limitaciones de los enfoques actuales de voz IA

Los enfoques actuales de la IA de voz tienen dos limitaciones principales que CAAI tuvo que abordar en el desarrollo de Moshi:

-

Latencia: La compleja canalización de modelos separados induce una latencia de 3 a 5 segundos entre la entrada del usuario y la respuesta del sistema. Esto puede ser extremadamente molesto para una experiencia conversacional en vivo.

-

Pérdida de información no textual: Al pasar por un cuello de botella basado en texto, el sistema pierde toda la información no textual, como la emoción, el tono y las señales de comunicación presentes en el habla original.

Para abordar estas limitaciones, CAAI adoptó un enfoque diferente. En lugar de usar una canalización compleja de modelos separados, diseñaron una sola red neuronal profunda "modelo de lenguaje de audio". Este modelo se entrena directamente en datos de habla anotados, sin la representación intermedia de texto.

Al comprimir la entrada de audio en una representación compacta de "pseudopalabras", el modelo de lenguaje de audio puede aprender los patrones y la estructura del habla, de manera similar a cómo los modelos de lenguaje de texto aprenden del texto. Esto permite que el modelo genere respuestas que preserven la riqueza del habla original, sin la latencia introducida por el enfoque basado en texto.

El resultado es una experiencia conversacional más natural y de baja latencia que captura toda la expresividad del habla humana.

Avances en el desarrollo de Moshi: multimodalidad, multistream y adaptabilidad

Avances en el desarrollo de Moshi: multimodalidad, multistream y adaptabilidad

Los avances clave en el desarrollo de Moshi, el modelo avanzado de IA conversacional, son:

-

Multimodalidad: Moshi no solo puede escuchar y generar audio, sino que también tiene pensamientos textuales que se muestran en la pantalla durante la conversación. Esto le permite aprovechar la eficiencia y compacidad del texto escrito junto con la riqueza del audio para proporcionar mejores y más rápidas respuestas.

-

Flujo múltiple: Moshi opera con dos flujos de audio paralelos, lo que le permite hablar y escuchar simultáneamente. Esto permite conversaciones más naturales con solapamiento de habla, interrupciones y un intercambio fluido, lo que hace que la interacción se sienta más humana.

-

Adaptabilidad: Moshi no es solo un modelo de IA conversacional de voz, sino un marco flexible que se puede adaptar a diversas tareas y casos de uso. El equipo demostró la capacidad de Moshi para participar en una discusión de los años 90/2000, mostrando su versatilidad y el potencial de interactuar con datos de diferentes períodos.

El motor TTS de Moshi y la síntesis de voz

El motor TTS de Moshi y la síntesis de voz

Una de las cosas más sorprendentes de Moshi es que no es solo un tipo de modelo de IA, sino un motor de texto a voz que tiene más de 70 emociones diferentes a las que se puede acceder. Utilizando los datos grabados, el equipo pudo entrenar un motor de texto a voz que puede admitir más de 70 emociones o estilos de habla diferentes.

Para mostrar las capacidades de este motor de TTS, el equipo reprodujo algunas muestras de audio generado. Las muestras demostraron la capacidad de Moshi para expresar una amplia gama de emociones, desde susurrar hasta cantar, e incluso imitar a un pirata o hablar con acento francés. Esto muestra la impresionante versatilidad y calidad realista de las capacidades de síntesis de voz de Moshi.

El equipo explicó que este motor de TTS se desarrolló internamente, lo que les permitió ajustarlo específicamente a las necesidades de Moshi. Al trabajar con una artista de voz llamada Alice, pudieron grabar varios monólogos y diálogos, que luego se utilizaron para entrenar el modelo de texto a voz. Este enfoque asegura que Moshi tenga una voz consistente y natural en todas las interacciones.

Entrenando a Moshi: de texto a IA conversacional

Entrenando a Moshi: de texto a IA conversacional

Los avances clave en el entrenamiento de Moshi, el modelo avanzado de IA conversacional, se pueden resumir de la siguiente manera:

-

Multimodalidad: Moshi no solo puede generar audio, sino también producir pensamientos textuales acompañantes. Este enfoque híbrido de combinar audio y texto permite un entrenamiento más eficiente y efectivo, lo que conduce a mejores respuestas.

-

Interacción de flujo múltiple: Moshi es capaz de escuchar y hablar simultáneamente, lo que permite un flujo conversacional natural con solapamiento de habla, interrupciones e intercambios fluidos, al igual que en las conversaciones humanas.

-

Generación de datos sintéticos: Para superar el desafío de los datos conversacionales reales limitados, el equipo desarrolló técnicas para generar diálogos sintéticos. Esto les permitió perfeccionar aún más las habilidades conversacionales de Moshi más allá del modelo de lenguaje inicial basado solo en texto.

-

Personalización de voz: Al trabajar con una artista de voz profesional, Alice, el equipo pudo dotar a Moshi de una voz consistente y natural en todas las interacciones, lo que mejoró aún más la experiencia del usuario.

-

Implementación en el dispositivo: El modelo de Moshi está diseñado para ser relativamente pequeño en tamaño, lo que permite implementarlo y ejecutarlo directamente en los dispositivos, asegurando la privacidad y las respuestas de baja latencia sin la necesidad de conectividad a la nube.

-

Consideraciones de seguridad: Reconociendo el potencial de uso indebido, el equipo ha implementado salvaguardas, como marcas de agua de audio y seguimiento de firmas, para detectar y mitigar la generación de contenido similar a Moshi con fines maliciosos.

Ejecutando a Moshi localmente en el dispositivo

Ejecutando a Moshi localmente en el dispositivo

Uno de los avances clave con Moshi es su capacidad para ejecutarse localmente en un dispositivo, sin requerir una conexión a Internet. Este es un avance significativo, ya que aborda las preocupaciones sobre privacidad y latencia que han afectado a los sistemas de IA de voz anteriores.

El equipo de CAAI demostró esta capacidad al ejecutar Moshi en una MacBook Pro estándar, con la conexión a Internet desactivada. Lanzaron la aplicación Moshi y pudieron participar en una conversación en tiempo real con el asistente de IA, sin ningún retraso o demora notable.

Esta ejecución en el dispositivo se hace posible por el tamaño relativamente pequeño del modelo de Moshi, que el equipo enfatizó que se puede comprimir aún más para su implementación en dispositivos móviles. Al ejecutar el modelo localmente, Moshi puede proporcionar una experiencia conversacional más fluida y privada, sin la necesidad de enviar datos de audio a un servidor remoto.

El equipo también discutió la importancia de la seguridad y el desarrollo responsable de sistemas de IA tan avanzados. Describieron dos estrategias clave para garantizar la integridad del contenido generado por Moshi: el seguimiento de firmas en línea y la marcación de agua. Estas técnicas permiten la detección de audio generado por IA, ayudando a mitigar el uso indebido potencial de la tecnología.

Garantizando la seguridad de la IA con Moshi

Garantizando la seguridad de la IA con Moshi

Uno de los últimos aspectos que la mayoría de las personas no pensarán es, por supuesto, el aspecto de la seguridad de la IA. Si tienes un modelo que es tan rápido y puede responder con un grado notable de precisión, sabemos que las personas podrían usarlo potencialmente para campañas de phishing u otras actividades maliciosas. Aquí es donde describen cómo van a identificar de manera segura el contenido de Moshi y asegurarse de que este no sea un problema generalizado.

Hola, soy de qAI. Nos tomamos muy en serio la seguridad. Una pregunta en particular que queremos abordar es cómo determinar si un audio ha sido generado por Moshi o no. Para esto, hemos considerado dos estrategias:

-

Enfoque en línea: Hacemos un seguimiento del audio que genera Moshi extrayendo algunas firmas y colocándolas en una base de datos de contenido generado. Cuando se nos presenta un nuevo audio, podemos extraer una firma y verificar si coincide con la base de datos. Si es así, sabemos que el audio fue generado por Moshi.

-

Marcado de agua: Agregamos algunas marcas inaudibles al audio que generamos, de modo que podamos detectarlas con un detector específico. Esto nos permite identificar el contenido generado por Moshi.

Estas son áreas de investigación activas que son importantes, desafiantes e interesantes. Estamos comprometidos a garantizar el desarrollo seguro y responsable de Moshi para prevenir cualquier uso indebido o actividades maliciosas.

Preguntas más frecuentes

Preguntas más frecuentes